AMD e NVidia: l’evoluzione della specie (parte 2)

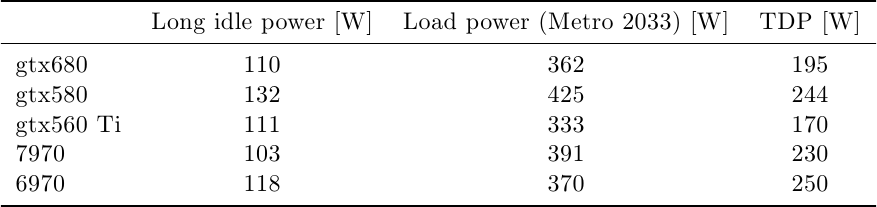

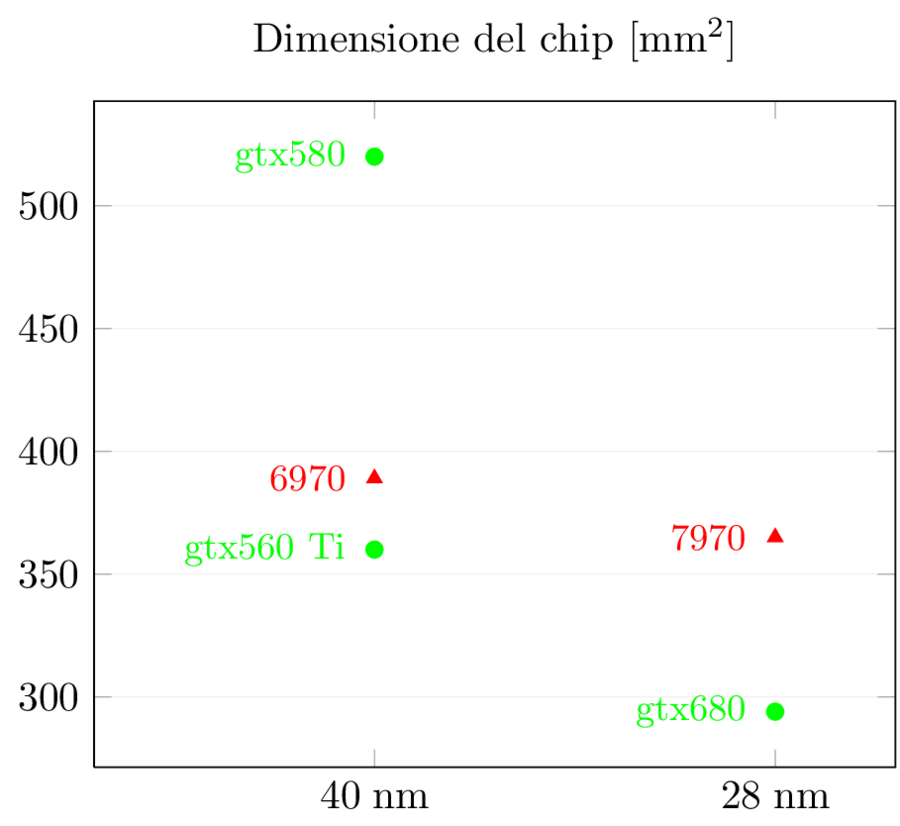

Dopo aver visto i numeri di base e le prestazioni per area delle nuove GPU…

AMD e NVidia: l’evoluzione della specie (parte 1)

Questi anni di rapide e dirompenti innovazioni tecnologiche stanno regalando grandi emozioni a tutti noi…

Notizie semi-accurate o semi-inventate?

Disclaimer: l'autore di questo pezzo lavora per una parte chiamata in causa dall'articolo che commenta,…

Branch prediction (parte settima): High-frequency fetch

Per trent'anni, prima che il raggiungimento del power wall terminasse la "corsa ai GHz" e…

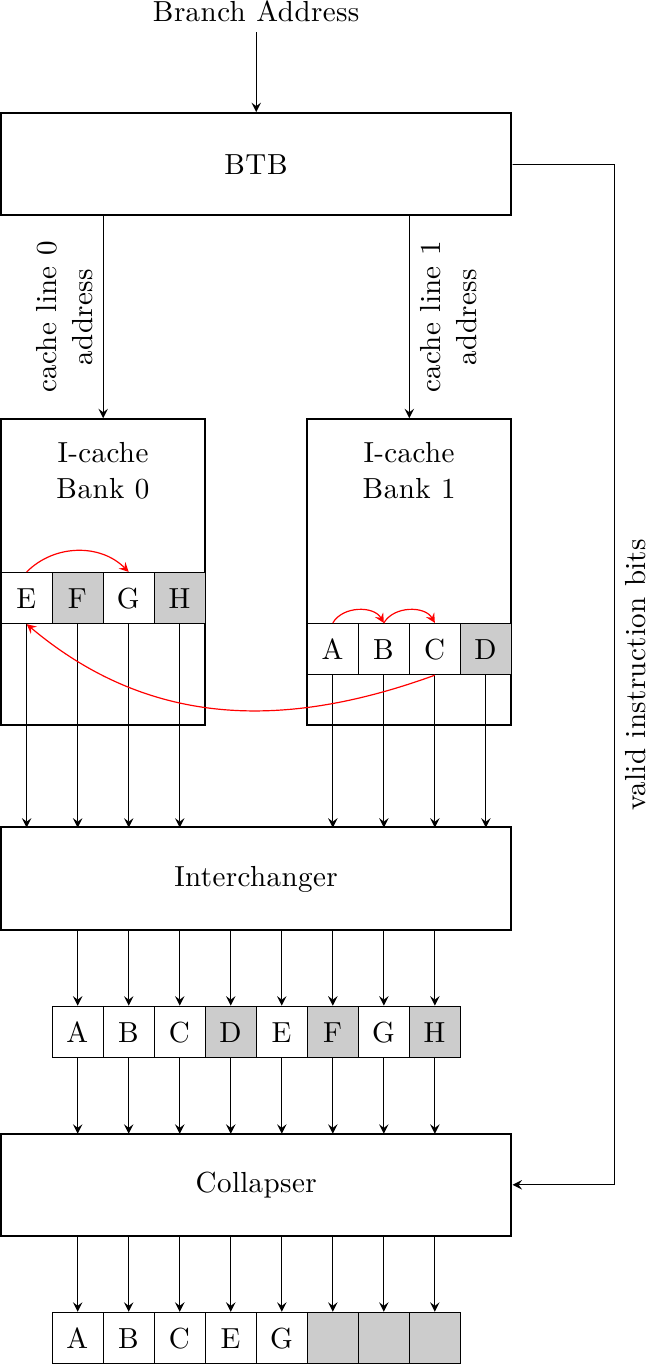

Branch prediction (parte sesta): High-bandwidth fetch

In tutta la discussione sui meccanismi di branch prediction (e siamo ormai alla sesta puntata!)…

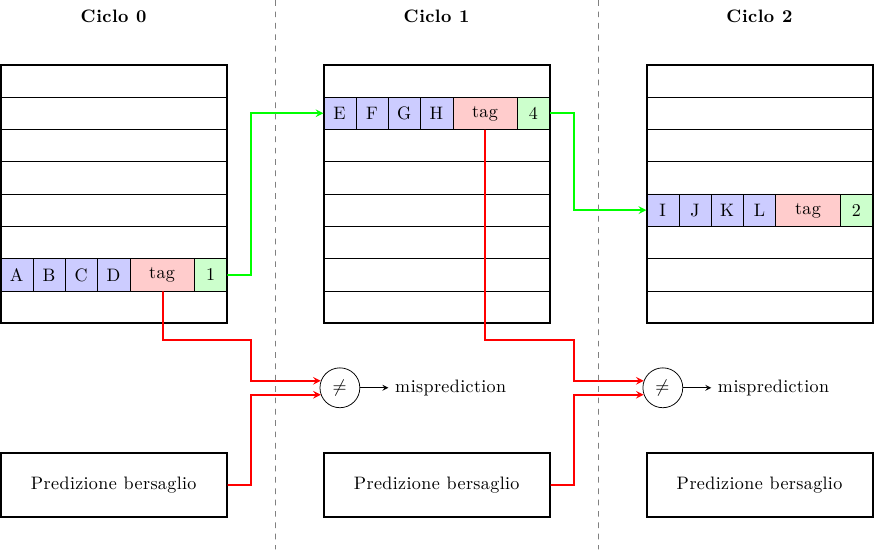

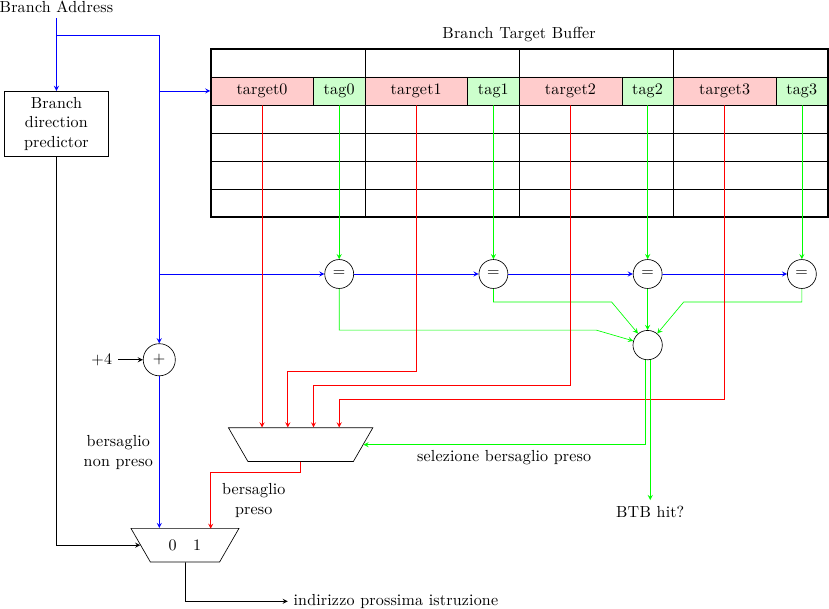

Branch prediction (parte quinta): Predizione del bersaglio

Negli scorsi articoli abbiamo visto alcune tecniche utilizzate dai processori moderni per predire la direzione…

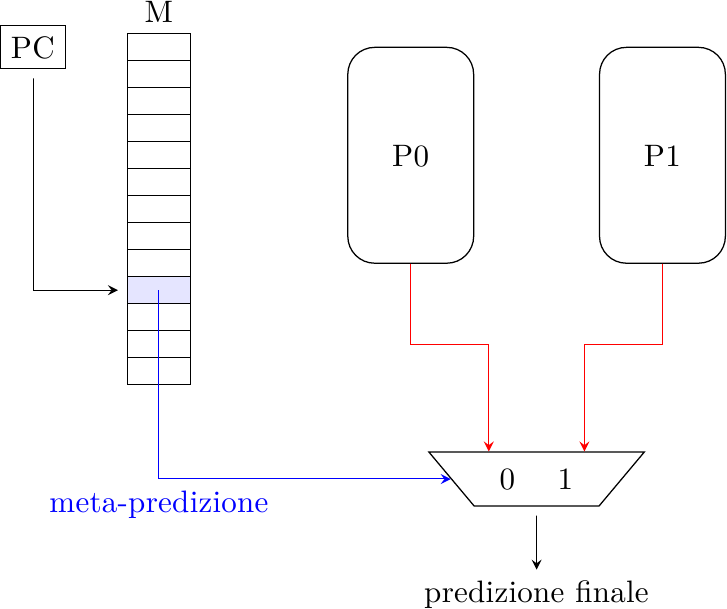

Branch prediction (parte quarta): Predittori ibridi

Nei precedenti due articoli (qui e qui) ho brevemente descritto alcuni schemi di branch prediction,…

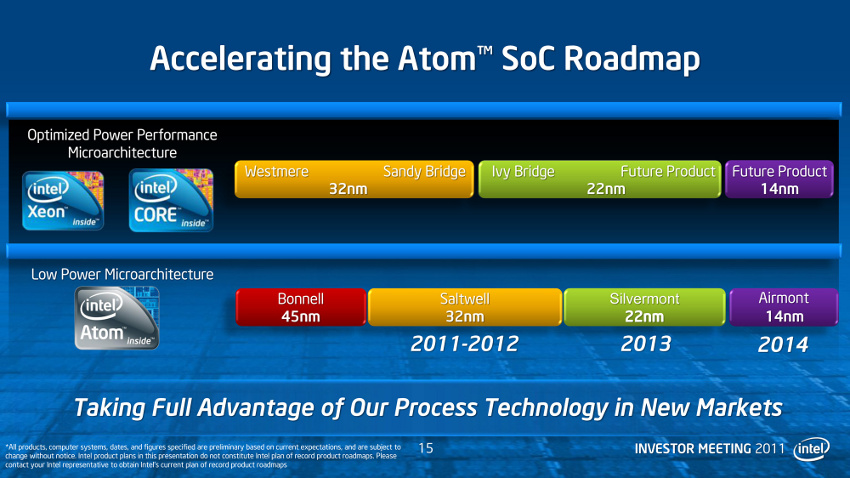

Intel come GlobalFoundries: una strada tutta da scoprire

Qualche giorno fa è comparsa su Reuters una strana e intrigante notizia a proposito di…

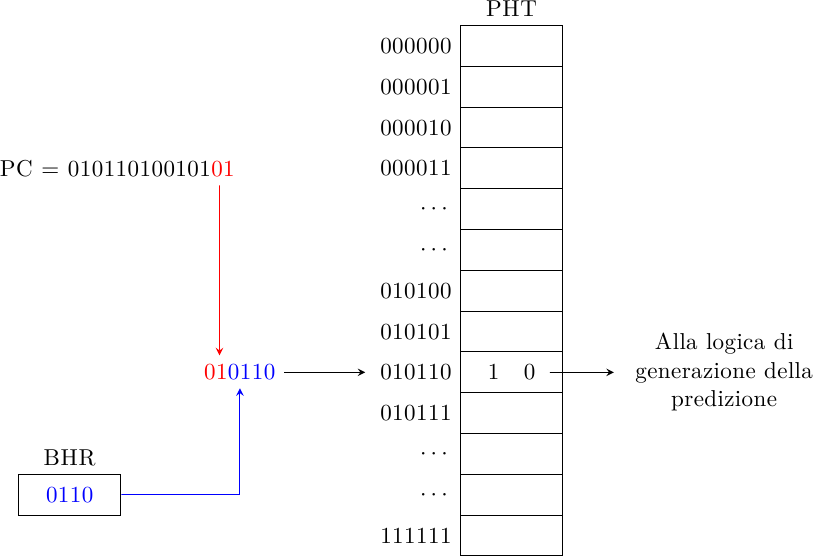

Branch prediction (parte terza): Predittori piu’ complessi

Nella seconda parte di questa rassegna sui branch predictor ho illustrato i fondamentali e gli…

Kepler, Maxwell, Denver, Tegra: dove va NVidia?

In una luminosa mattina californiana del novembre 2010, Jensen Huang, fondatore, presidente e CEO di…