Purtroppo e per fortuna i mesi milanesi sono stati e saranno intensi ma vi assicuro che siete sempre stati nei miei pensieri.

Ci sono ancora molti fronti aperti: il Giappone, titoli che hanno fatto la storia di questo settore, curiosità, vostre richieste da esaudire.

Ed a tempo debito verranno trattati e chiusi. Parola di lupetto.

Ma quest’oggi vorrei riflettere su quel che il mercato ci propone e soprattutto potrà offrirci negli anni venturi.

Credo che nessun appassionato, più o meno competente, si sia sottratto al totoscommesse di questi ultimi mesi.

Tantomeno i ragazzi di AD.

L’argomento era però talmente vasto da rendere difficile la scelta stessa di un titolo appropriato.

Anche perché, voi mi insegnate, il titolo è la frase più importante, ancor più nel Web dove assume la valenza di meta tag.

Cercando tra le varie fonti ho recuperato un post di due anni e mezzo fa, edito proprio su Appunti Digitali.

Forse qualcuno se lo ricorda, ma sostanzialmente criticava tutto l’esasperato hype commerciale racchiuso dalla parola “next-gen”, usata, impropriamente o meno, per rappresentare uno stacco netto tra l’attuale generazione di console e videogiochi comparata a quella precedente.

Fermo restando che non esista né credo esisterà mai una definizione univoca, dovremmo anche cercare di capire se si possa parlare realmente di evoluzione o rivoluzione. E se questo valga per tutti gli attori dell’industry.

Ci torneremo, magari sulla scia di qualche vostro spunto interessante.

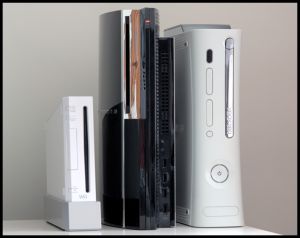

Ma ora, ora che stiamo vivendo questa fantomatica “next-gen”, dopo aver visto evolvere molteplici scenari quali il bruco Wii conquistare la fetta principale del mercato, la Sony riguadagnare consensi per perdere parzialmente la faccia con il disastro PSN, a 6 anni dall’entrata ufficiale con la 360 di questa ultima generazione, cosa dobbiamo aspettarci?

La chiameremo “next next-gen”?

E quali saranno i prodotti su cui muoveremo le nostre frenetiche dita di videogiocatori?

Partiamo dalle certezze. Nintendo ci ha insegnato che non esiste un normotipo di acquirente, ne esistono molteplici, molto diversi tra loro. E più si è in grado di allargare questo spettro, più un prodotto può raccogliere consensi. Il successo, inaspettato, insospettabile per direi la quasi totalità degli addetti ai lavori (tranne la stessa casa giapponese) ne è stata la riprova.

Un’architettura partorita già obsoleta quando calcò il palco commerciale nel 2007, in grado di surclassare in termini di vendite sia Sony sia Microsoft.

Scelta che non solo ha pagato in termini di numeri assoluti ma anche perché, ribaltando il business model al quale eravamo abituati, ogni unità venduta non rappresentava un piccolo/grande segno meno nella contabilità da dover rimpinguare con il sistema delle royalty.

La filosofia della grande N intrapresa dalla visionaria mente di Gunpei Yokoi è diventata lo strumento con il quale attrarre il potenziale acquirente, più o meno esigente.

Come il Gameboy seppe surclassare Lynx e Game Gear, così, anche se con proporzioni differenti, Wii ha saputo stupire PS3 e 360.

La “user experience” è quindi posta al centro dei pensieri degli sviluppatori odierni.

D’altra parte, il gioco della minestra riscaldata non può sempre funzionare e per convincere le software house dedite soprattutto al PC gaming occorre proporre un progetto al passo coi tempi.

E’ il momento di tirare fuori l’arrosto.

E’, o meglio verrà, il turno della Wii U.

[youtube QzaRme9vPpA]

La presentazione, senz’altro affascinante, ha avuto il compito anche di compensare l’accoglienza piuttosto fredda avuta nei confronti del 3DS. Il prezzo alto di vendita certo non ha controbuito, ma di contro per esempio, la PS Vita ha suscitato molto interesse.

Nintendo si è accorta di avere commesso qualche errore nella strategia commerciale e memore degli errori commessi in passato anche dai propri avversari non ha perso tempo per tenere alta la tensione e catalizzare l’attenzione dei media.

In questo senso vanno anche interpretate le varie voci, molto reclamizzate, sull’interesse da parte di Bethesda, Valve ed altri devteam che si aspettano prestazioni adeguate per poter effettuare porting o proporre titoli ex novo sulla nuova piattaforma.

I nodi architetturali devono essere ancora sciolti anche se si rincorrono insistenti voci sull’adozione.

Ma come San Tommaso, finché non vediamo non crediamo. E quindi i numeri sparati nel mucchio non ci impressionano particolarmente (“il doppio più potente della PS3”).

Esaurito il fronte della “lepre”, passiamo a chi attualmente insegue.

Microsoft ha dimostrato con le sue scelte architetturali di facilitare il compito agli sviluppatori beneficiandone quasi fin da subito.

Non è un caso che i titoli multipiattaforma abbiano quasi sempre avuto una resa migliore proprio sull’Xbox 360.

Mediamente il ciclo di vita di una console si attesta sui 5-6 anni, anche se la storia è piena di negative e positive eccezioni. Ricordiamo le primissime uscite della quinta generazione con le sfortunate e poco lungimiranti Amiga CD32 o 3DO, contrastate da successi interplanetari come la PSX o la successiva PS2.

Lo stesso Neo Geo, seppur rappresentando un unicum sfugge a questa regola non scritta.

Certamente il settore è cambiato, il business model è diventato molto più complesso e le fonti di revenue aumentate così come il parco giocatori.

Ma è aumentato anche il costo di progettazione, quello per lo sviluppo di ogni singolo titolo e quindi anche il rischio di prendere una cantonata vale cifre decisamente più alte dei tempi in cui SEGA e Nintendo si contendevano il mercato.

Ormai molti parlano apertamente di crisi, soprattutto di idee, come aveva denunciato in tempi non sospetti Hideo Kojima.

Prende quindi il largo il settore mobile perché può attingere ad una base complessivamente molto più significativa rappresentata dai cellulari di fascia alta o smartphone che a dir si voglia.

Ma anche su questo aspetto torneremo nel prossimo futuro.

Microsoft ha quindi tutto l’interesse a prolungare fin quanto possibile la presenza sul mercato della 360, che ormai non viene più venduta in perdita dal 2009.

Lo stesso Kinect, va visto anche in quest’ottica.

D’altra parte, se computazionalmente non è possibile generare un output nativo di 1080p nei videogiochi “tradizionali” (mantenendo un framerate accettabile), a maggior ragione è impossibile farlo mettendo in campo il sistema di riconoscimento dei movimenti/suoni proposto dal Kinect stesso.

L’esperienza utente viene arricchita ma sia il produttore HW (Microsoft), sia i publisher che le software house sono ben consci della necessità di porre le basi per la generazione futura.

A mio modo di vedere, credo che per sfruttare davvero il sistema di puntamento coniugandolo con il FullHD e la visualizzazione 3D nemmeno il prossimo step sarà sufficiente.

Se dovessi scommettere su una data direi non prima del 2020 o giù di lì, quando assisteremo all’uscita della nona generazione di console.

Per Microsoft vi è un altro nodo da sciogliere.

Il DVD dual layer sta diventando ormai un contenitore troppo limitante per la capienza dei contenuti che vorrebbero essere veicolati.

E nel giro di due anni, nonostante il servizio Live sia ormai una certezza, le connessioni ad alta velocità non potranno ancora sostituire completamente il buon vecchio supporto ottico.

Insomma, digital delivery sì ma con parsimonia.

Quindi? Affondato l’HD-DVD, rimarrebbe il Blu-Ray la cui adozione però significherebbe regalare royalty per ogni copia del gioco venduto al competitor Sony.

Ci sarebbero le ventilate ipotesi dell’HVD ed affini ma restano ancora progetti su carta, al momento lontane dal diventare prodotto-scaffale.

Restiamo anche in questo caso alla porta curiosi di vedere le strategie commerciali, per ora abbastanza taciturne della Microsoft.

Ci sono voluti ben due anni per avere la prima killer application su PS3.

Il costo spropositato dei componenti ha generato inizialmente una perdita secca per console di 300$.

Il break-even del guadagno sulla parte hardware (senza conteggiare gli investimenti nel marketing, packaging e via discorrendo) è stato raggiunto solo dopo 4 anni, nel giugno 2010.

Howard Stringer, CEO Sony, si era perfino spinto a definire irrecuperabile l’iniziale passivo generato.

Le iniziali perplessità sul poco bilanciamento tra comparto grafico e comparto CPU restano ancora in parte irrisolte, così come l’adozione del Cell, gli ingenti investimenti nella progettazione e rilascio (presente sì nell’ambito del supercomputing ma certo non nei sistemi desktop, come avrebbe dovuto insegnare il fallimento Itanium) risultano ancora un grande rebus.

D’altra parte, abbandonare questa strada intrapresa significherebbe un vero e proprio bagno di sangue economico come avevano ben sottolineato Cesare Di Mauro e recentemente Fabio Bonomo.

Più percorribile la strada di un aggiornamento della GPU, probabilmente ancora Nvidia in virtù dei precedenti accordi commerciali presi e magari un po’ di “steroidi” proprio per la CPU, aumentando la RAM del sistema e le specifiche di ogni singola SPE.

Nonostante alcuni rumor di dubbia provenienza su un fornitore taiwanese avrebbe ventilato la fornitura e produzione di unità PS4 entro 6 mesi, non vedo la praticabilità di questa ipotesi.

Sony ha impiegato notevoli sforzi, perdendo la leadership sul mercato ma almeno rendendo la PS3 un prodotto “established“ nell’immaginario collettivo.

Gli utenti sarebbero disposti a reinvestire i propri danari per un ennesima piattaforma? E’ tutto da vedere.

Inoltre, di solito, si tende a rimpiazzare la generazione precedente quando il break-even è stato ottenuto durante la seconda parte del ciclo di vita: una seconda parte che deve essere più duratura della prima.

In parole povere, dismettere un prodotto e reinvestire sul nuovo quando si è cominciato a guadagnare da relativamente poco sul vecchio non ha commercialmente molto senso, a meno che non sia strategia per aggredire un mercato in cui un’azienda non era finora impegnata: vedere l’esempio della prima Xbox.

Sony tra l’altro ha dovuto fronteggiare un grosso smacco di immagine relativamente al caso dell’attacco subito dal Playstation Network, alias PSN. Seppur addetti ai lavori si siano spesi nella valutazione monetaria, è difficile quantificare il reale impatto economico. Ma con la PS Vita alle porte, siamo sicuri che la Sony sia disposto ad un altro grosso esborso nel giro di un anno, data in cui secondo lo stesso Hardware Upgrade ed altri operatori, dovrebbe entrare in commercio la PS4?

Ne dubito fortemente anche se aspetto smentite.

Sony stessa ha dichiarato negli anni scorsi che questo progetto sarebbe durato una decina d’anni.

Forse dieci no perché gli altri competitor rischierebbero di andare troppo avanti, ma il 2013 o 2014 parrebbero date più verosimili, Maya permettendo.

Ma, se mai si dovessero rimangiare le promesse fatte all’utenza ed alla stampa per abbreviare i tempi, è difficile credere ad una rivoluzione.

Ed in ogni caso, un conto sono dieci anni di presenza sul mercato come unica piattaforma di riferimento, un altro paio di maniche è vederla come trait d’union (e magari retrocompatibilità) con la PS4.

La prima ipotesi, al di là delle più ottimistiche dichiarazioni, sembra altrettanto poco credibile.

Per motivi commerciali, ma non solo, le software house cercano di non inimicarsi troppo i propri partner e così viceversa. E’ altresì chiaro che le potenzialità offerte dall’utilizzo del corpo umano come estensione naturale dei tradizionali sistemi di puntamento richiedono il superamento delle attuali architetture.

Ubisoft è stata piuttosto netta sull’argomento.

La fisica, l’IA, gli storyboard, le tecnologie di riconoscimento facciale (come l’ultimo MotionScan particolarmente apprezzato in L.A. Noire) sono tutti aspetti del gioco in cui c’è ancora molto da lavorare e dove si può investire.

Quando potremo però assistere ad un deciso superamento delle attuali limitazioni?

Gli alti costi di sviluppo e l’eccessiva frammentazione di risorse nel supportare tre pari (almeno sulla carta) concorrenti costringeranno questi ultimi ad una sorta di più o meno tacita convergenza di intenti.

Nintendo, dopo aver puntato decisa sull’esperienza utente deve recuperare il gap prestazionale accumulato.

Mentre Sony e Microsoft dopo essersi scontrate sul piano “multimediale”, devono cercare di convincere i casual gamer a guardarsi intorno e dimostrare che la Wii non è l’unica scelta possibile.

Come sempre, stay tuned, perché ne vedremo certamente delle belle.