La mancanza di software professionale per il pinguino è sempre stata additata come una delle cause principali della scarsa diffusione di GNU/Linux nei PC domestici. La motivazione è spesso stata utilizzata a sproposito visto che in realtà software professionali esistono (mi vengono in mente alcuni programmi di CAE, fluidodinamica o grafica 3D).

Quello che molti chiamano software professionale può essere inquadrato in quella fascia intermedia ben descritta dal termine termine “prosumer“. Per intenderci mi sto riferendo a quella famiglia di software scatolati che si trovano nella fascia di prezzo tra i 30€ e i 100€.

I motivi che vengono in mente per spiegare questa mancanza sono molteplici:

- Necessità di riscrivere il proprio programma per una piattaforma su cui non si ha esperienza

- Scarsa diffusione della piattaforma tale da non giustificare la spesa

- Scarsa comprensione dell’ecosistema

- Serrata concorrenza di alternative libere

È facile notare come le motivazioni appena esposte dipingano un quadro che potremmo definire il classico “circolo vizioso”. Le cose però sembrano destinate a cambiare e già possiamo vedere le prime avvisaglie.

La prima è la comparsa di alcuni software “storicamente” orientati al mondo Windows. Parlo per esempio dell’annuncio degli sviluppatori di uTorrent riguardo al porting del loro famosissimo programma. Non che si senta il bisogno impellente di un altro client torrent, visto che esistono molteplici e valide alternative dal cuore aperto, ma la notizia fa capire che il desktop GNU/Linux inizia a entrare nei piani di chi in passato non lo considerava minimamente.

Altro caso recente è il rilascio della nuova versione di Guitar Pro che con la versione 6 è presente per tutte le piattaforme (MacOSX, GNU/Linux, Windows). Qui il merito va anche al framework Qt utilizzato per lo sviluppo che ha permesso di condividere grandissima parte del codice del progetto.

Vale la pena ricordare inoltre che Valve sta attualmente lavorando al porting del client Steam per GNU/Linux.

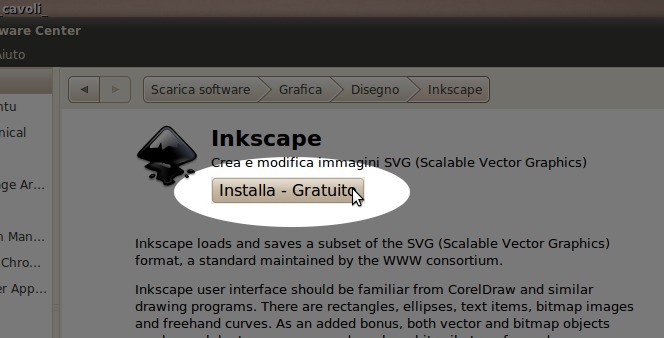

Se aggiungiamo a tutto questo un blueprint del Software Center di Ubuntu apparso su launchpad il 15 Giugno che recita:

Buy something in the software center

In Maverick we will offer *one thing* for sale to end users.

= In scope =

* Something, at least one thing, is available for purchase from the software center= Out of scope =

* ability to add arbitrary items to the software center for sale

* self-service of adding items for sale

Possiamo capire come lentamente qualcosa si stia muovendo.

Personalmente sono un fermo sostenitore del software libero ma considero positivamente questi segnali. Se da un lato continuerò a utilizzare e possibilmente sostenere i progetti che utilizzo e che mi piacciono, dall’altro l’idea di avere una alternativa commerciale in certi ambiti non mi dispiace affatto.

Tra gli altri vantaggi la disponibilità di software commerciale potrebbe avvicinare tutti coloro che si vedono costretti a rimanere ad ancorati ad un sistema per un singolo programma. Ed un aumento di base installata porterà certamente a migliormaneti e investimenti in altri campi. Miglioramenti che saranno utili a tutti… anche a quelli che vorranno continuare a utilizzare soltanto software libero (scelta che ovviamente considero rispettabilissima).

Voglio quindi sbilanciarmi affermando che non solo la convivenza è possibile… ma è anche auspicabile.

Voi cosa ne pensate?