Pubblichiamo un guest post di Lorenzo Tosetto

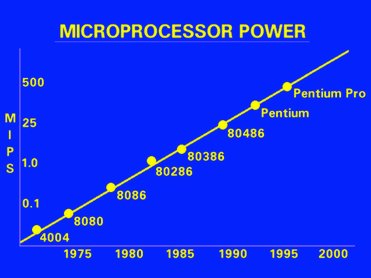

Non c’è bisogno di essere fisici, ingegneri, o comunque addetti al settore per aver sentito parlare della famigerata previsione che, nonostante cinquant’anni di correzioni, riformulazioni, estensioni e corollari, sostiene fondamentalmente sempre lo stesso concetto: l’innovazione tecnologica è sufficientemente veloce da permettere di crescere sempre più dispositivi su una data area di semiconduttore (un parametro noto come “densità di integrazione”). E questo concetto la legge di Moore lo sostiene a piena ragione.

Quello che magari è oscuro ai più è perché – con l’attuale tecnologia- si inizia a fare fatica a tenere il passo ad un raddoppio di densità ogni (diciamo) due anni.

Senza pretese di completezza (in caso di interesse, anche il numero di ottimi libri sulla fisica dei dispositivi segue la legge di Moore), il mio obiettivo è quello di spiegare brevemente perché stiamo arrivando al limite tecnologico e quali sono le prospettive future.

Crescere un dispositivo significa, in parole veramente povere, prendere un wafer di semiconduttore (generalmente Silicio), scavare le zone dove vogliamo inserire, ad esempio, i tre terminali di un transistore e riempire i buchi con materiale opportuno, avendo poi cura di contattare il tutto per il passaggio della corrente.

Non è difficile comprendere come, nell’inserire miliardi di elementi in un wafer di una manciata di pollici di diametro, la precisione necessaria nel “disegnare” sul semiconduttore le zone che verranno scavate è un fattore chiave.

Per questo processo si utilizza un metodo vecchio come il mondo: l’ombra. Si disegnano su una lastra trasparente le zone da scavare, si rende opaco tutto il resto e il gioco è fatto: la luce passa solo attraverso le zone trasparenti e impressiona una particolare resina (photoresist) spalmata sulla superficie del wafer, proprio come una fotografia. La resina impressionata si stacca e lascia scoperte le zone da scavare.

Qual è il problema? Un fenomeno fisico particolarmente subdolo chiamato diffrazione, il cui effetto è quello di “sbrodolare” la luce se questa incontra un ostacolo dello stesso ordine di grandezza della sua lunghezza d’onda. L’attuale tecnologia utilizza lampade DUV (Deep UV) che, con particolari lenti, permette dimensioni minime di 50nm circa.

E’ chiaro dunque che uno dei limiti nello scaling dei dispositivi è quello di riuscire fisicamente a disegnarli sul wafer: per fare un esempio molto libero, è come tentare di fare un disegno piccolo e dettagliato usando un Uni Posca.

Ovviare a questo problema è oggetto dell’attuale ricerca in nanolitografia, dedita all’ambizioso tentativo di implementare metodi litografici fino a scala atomica.

Un secondo problema nello “scaling down” dei transistori risiede nel fatto che, riducendo tutte le dimensioni, si riduce anche lo spessore dello strato di dielettrico (ossido di Silicio) che costituisce il gate, l’elemento fondamentale del dispositivo.

Uno spessore troppo ridotto può causare un fenomeno chiamato tunneling: gli elettroni sul gate, che dovrebbero comportarsi come in un condensatore, riescono a penetrare la barriera di ossido creando una corrente che può deteriorare pian piano il materiale, aumentando sempre più e letteralmente “bruciando” il dispositivo.

La stessa cosa può avvenire se ad esempio il canale sottostante il gate è troppo corto: una vicinanza eccessiva tra zone a diverso potenziale può creare campi elettrici particolarmente estremi e conseguenti scariche elettriche dannose per il corretto funzionamento.

Una miriade di altri problemi (capacità che limitano la frequenza operativa, dissipazione efficace della potenza, etc…) vanno risolti nel tentativo di scalare le dimensioni, ridurre i costi e soprattutto migliorare il funzionamento dei dispositivi, qualunque sia il parametro usato per valutarlo.

Dove stiamo andando? Cosa ci riserva i futuro? E’ difficile dirlo: la ricerca è attiva in una sterminata serie di campi diversi fra loro, uno per tutti il famoso computer quantistico, in cui lo spin degli atomi immagazzina le informazioni proprio come i bit in un computer classico.

Le stime riguardanti i limiti della legge di Moore sono quanto mai eterogenee, ma una cosa è certa: la ricerca è più florida che mai anche nel “vecchio” mondo dei dispositivi a semiconduttore, e chi si aspetta l’avvento di nuovi dispositivi di concezione completamente diversa dovrà probabilmente accontentarsi di fantascientifiche speculazioni.

A meno che, in agguato in un angolo della scienza, ci sia la famosa singolarità tecnologica, pronta a proiettarci nel mondo della fantascienza.