Post Precedente: Da Interface Manager a Windows 8, Windows al Bivio: OS/2 e le “furbizie” contro Digital Research

Continuiamo il nostro viaggio attraverso la storia di Windows con il terzo post relativo ai 25 anni dell’ambiente di Microsoft.

NT e l’approccio “document centric” di Chicago

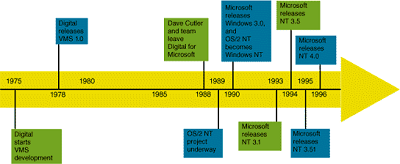

Parallelamente a Windows 2.x/3.x, Microsoft è impegnata nella realizzazione di un nuovo sistema operativo, che basa la propria ragion d’essere su due elementi primari: le nuove CPU basate su architettura RISC, profondamente diverse da quelle x86 di Intel, e l’avanzata dei sistemi UNIX like negli ambiti professionali e di rete.

Gates assolda, nel 1988, David Cutler e da vita al progetto OS/2 NT, pensato per creare un nuovo kernel “portable” e utilizzare le API di OS/2. Comincia così lo sviluppo di un sistema minimale, basato su kernel ibrido, identificato con la sigla “NT”. La sigla deriva, con ogni probabilità, da “N-Ten”, l’emulatore della CPU Intel i860 sul quale era iniziato lo sviluppo del progetto, così come sostenuto anche da Mark Lucovsky, stretto collaboratore di Cutler (ne abbiamo parlato qui).

Il progetto prosegue indipendentemente da Windows, anche se il successo senza precedenti della versione 3.0 convince il big di Redmond a sostituire le API di OS/2 con un’API a 32bit derivate da quelle di Windows 3.x e denominate Win32 API. Il tutto, ovviamente, per offrire all’utente finale un ambiente familiare e ai programmatori un set di strumenti che si basa sul know-how precedente. NT viene inoltre re-ingegnerizzato in modo da poter eseguire molte delle applicazioni Win16 e Dos, affiancando il già pianificato supporto a quelle basate sulle API POSIX.

Nasce così Windows NT, con “NT” che assume il significato odierno di New Technology, principalmente per motivi di marketing.

NT Origin

Ma Microsoft non si accontenta e nonostante NT non sia ancora stato rilasciato, pensa già a come estenderlo, creando, tra il 1991 ed il 1992, un team, alle dipendenze di Jim Allchin, per un nuovo progetto: CAIRO. Uno degli aspetti centrali di CAIRO è la realizzazione di un sistema operativo che sia in grado di organizzare i file non solo attraverso il loro nome, ma soprattutto attraverso il loro contenuto. L’obiettivo globale, però, è ancora più ambizioso: abbattere definitivamente il concetto di “localizzazione”, rendendo trasparente all’utente finale il fatto che i file siano sul PC locale o in rete. Questa tecnologia prende il nome di Object File Store (OFS), e negli anni a venire sarà conosciuta come WinFS.

Windows NT viene ufficialmente rilasciato nel Maggio del 1993 nella versione RTM (Release to Manufactoring) e raggiunge gli utenti consumer (ad Agosto), nelle versioni NT 3.1 e NT 3.1 Advanced Server. La versione di partenza è la 3.1 in modo da creare il parallelo con la famiglia dos-based, da cui, come detto, NT eredita l’interfaccia utente. Le piattaforme supportate sono l’x86, DEC Alpha e MIPS (processori R3000 e R4000).

Windows NT 3.1 Logo

NT è basato su una struttura a kernel ibrido, supporta 2 CPU (SMP) ed è in grado di gestire fino a 64Mb di Ram. Per quanto riguarda la gestione del disco e dei file, fa la sua comparsa i nuovo file system NTFS, derivato direttamente dall’HPFS di OS/2. Il supporto al file system FAT è comunque garantito. Altre importanti caratteristiche sono: uno scheduler preemptive, gestione e creazione di reti integrate, sottosistemi per OS/2 e POSIX.

L’architettura completamente a 32bit consente alle applicazioni native di sfruttare fino a 2GB di memoria in modalità Protected, ovvero ogni applicazione ha un’area di memoria riservata a cui le altre non possono accedere. Ciò consente di garantire un’alta stabilità funzionale e di non compromettere il funzionamento dell’intero sistema nel caso in cui una delle applicazioni vada in crash.

Come ogni prima release, NT 3.1 soffre di alcuni problemi funzionali e di affidabilità, uniti alla scarsità di software e dei driver specifici; inoltre le risorse hardware richieste sono superiori a quello che è lo standard tecnologico del periodo. Tutto ciò relega NT 3.1 ad una stretta nicchia di professionisti, restando praticamente sconosciuto alla maggioranza dell’utenza business e consumer.

Nel frattempo CAIRO, la cui data di rilascio è prevista per l’anno seguente (1994), comincia ad essere interessato dai primi rinvii ufficiali e in Microsoft si delinea sempre una nuova strategia: più che un nuovo OS, CAIRO sarà incubatore di una serie di tecnologie per i futuri NT e il nascente CHICAGO (alias Windows 95).

Con queste premesse i team di Cairo ed NT vengono fusi e Allchin viene posto alla guida del progetto NT “Extended”, scalzando Cutler. Nel 1994 viene rilasciato il nuovo NT 3.5, nelle edizioni Workstation e Server.

Windows NT 3.5 Logo

Si tratta, fondamentalmente, di una ottimizzazione della versione precedente, che migliora le prestazioni e garantisce una maggiore stabilità operativa. Anche le risorse minime diminuiscono: ora sono sufficienti 12 Mb di Ram. La nuova versione porta in dote l’ultima release di Object Linking and Embedding (OLE) che migliora l’efficienza delle operazioni di scambio tra le applicazioni, il supporto a VFAT e quello alle librerie per il 3D OpenGL.

La versione Workstation è ottimizzata per l’accesso alle applicazioni, mentre la versione Server ha un nuovo sottosistema di I/O e funzionalità di interconnessione tra le reti, in particolare con Novell Netware. Molti i protocolli supportati: RAS (Remote Access Services), SLIP (Serial Line Internet Protocol), PPP (Point-to-Point Protocol), DNS (domain name servers).

NT 3.5 supporta, inoltre, le piattaforme RISC-based: Alpha AXP, R4x00 MIPS. Per il supporto a PowerPc e a SPARC bisogna attendere Maggio del 1995 con NT 3.51 che, inoltre, migliora sensibilmente le performance di NTFS.

Nella visione di Gates tutto questo, però, ancora non è sufficiente.

Anche se è innegabile che Windows 3.1x, Windows NT 3.1/3.5x, ed i vari progetti paralleli, hanno proiettato la casa di Redmond verso un dominio senza antagonisti nel mondo dell’informatica mondiale, è anche vero che la modalità di approccio è rimasta sostanzialmente invariata.

L’uso del computer è infatti ancora “application centric”, quindi l’interazione dipende fortemente dall’applicazione che si utilizza. Proprio qui si inserisce CHICAGO, nome in codice di quello che il 24 agosto del 1995, con una campagna marketing senza precedete, viene presentato al mondo con il nome di Windows 95.

Windows 95 Logo

Il nuovo Windows è diverso nella “filosofia”, tant’è che il progetto è nelle mani di Brad Silverberg, e non in uno dei precedenti Team Lead o Vice President.

Al di là delle innovazioni tecnologiche, del supporto ai nuovi standard (leggasi plug&play) e alla favoletta dell’indipendenza dal DOS, la vera rivoluzione del nuovo Windows è che il modus operandi degli utenti si sposta verso il paradigma “document-centric”. Per la prima volta gli utenti utilizzano un ambiente in cui possono focalizzandosi sulle proprie attività e non sulle applicazioni da usare.

Tutto è pensato per questo: la nuova interfaccia 3D like con il pulsante Start, un vero “desktop” su cui riporre qualsiasi tipo di oggetto, un file system che supporta nomi lunghi e così via. Anche i vecchi Program Manager, File Manager e Print Manager di Windows 3.xx scompaiono e lasciano il posto ad Explorer, una shell evoluta che ne accorpa le funzionalità e ne semplifica l’utilizzo.

document centric

L’aspetto più innovativo è che ogni elemento (icona, documento, file, ecc.) è un “oggetto” con delle proprietà ben definite, ed è in grado di modificare l’interfaccia guest in modo da visualizzare ed abilitare le relative funzioni.

In realtà Microsoft non dice tutta la verità sul nuovo OS, così come evidenziato da Andrew Schulman in Unauthorized Windows 95. In particolare Win95 non è un vero OS integrato, essendo composto da Windows 4.0 ed MS-DOS 7.0, nascosto abilmente agli occhi dell’utilizzatore. Ciò influisce sulla “purezza” del kernel, che non è interamente a 32bit ma è un ibrido 16/32 bit, e sulla difficoltà di isolare completamente le applicazioni al fine di evitare crash del sistema nel caso una sola applicazione smetta di funzionare, come invece avviene in NT.

Windows 95 diviene il prodotto di maggior successo nella storia del software e il concetto “document centric” viene ripreso ad un anno di distanza (1996) con Windows NT 4 che, comunque, mantiene le peculiari caratteristiche di stabilità grazie alla differente architettura in cui le librerie grafiche (GDI) sono interamente a 32 bit e, insieme ai driver relativi, vengono gestite direttamente dal Kernel (Kernel Mode), garantendo stabilità ed efficienza. Nel caso di Windows 95, invece, le funzionalità di gestione della GUI girano in User Mode e soffrono di evidenti problemi di stabilità.

Ovviamente, essendo pensato per il mondo professional, NT 4 offre un importante supporto agli ambienti di rete e alla gestione degli utenti. Nonostante il mancato supporto all’USB, e quindi la limitata compatibilità con il nuovo hardware, questa release di “New Technology” proietta Microsoft nel mondo dei sistemi operativi server, prima ad esclusivo appannaggio di Unix e soci, ponendo una seria ipoteca sul futuro.

NT 4 Server

Nel frattempo l’avanza di Internet è diventata ormai realtà e Microsoft, che inizialmente aveva snobbato la rete creando solo in un secondo momento il proprio browser, è al lavoro su Nashville, una versione intermedia tra Windows 95 e Memphis (alias Windows 97, prima, e 98, dopo) che ingloba anche componenti comuni con Windows NT 4. Nashville rafforza proprio l’integrazione con Internet Explorer che ora è in grado di visualizzare documenti di Office, mentre il desktop si trasforma in Active Desktop, capace di visualizzare direttamente pagine web.

Proprio questa sua identità di sistema-aggiornamento, porta spesso a riferirsi ad esso come Windows 96. Il progetto, comunque, viene cancellato poiché le relative innovazioni trovano posto nei vari service pack per Windows 95, da OSR2 alla OSR2.5c, che introducono anche: la fat32, il supporto all’USB ed ovviamente Internet Explorer di “serie”. Anche NT 4 beneficia di aggiornamenti derivati direttamente da Nashville nei vari Service Pack.

Nel 1998 arriva Windows 98, curato dalle prime fasi di design fino al rilascio da Moshe Dunie, Vice presidente della Windows Division di Microsoft. Si tratta in sostanza di un raffinamento del suo predecessore, tant’è che siamo di fronte alla versione 4.1 del sistema operativo e non ad una 5.0. Anche il DOS persiste nella sua condizione “nascosta” e viene aggiornato alla versione 7.1.

La nuova versione sfoggia un look migliorato, una nuova architettura per lo sviluppo dei driver, WDM (Windows Driver Model), ed una più profonda integrazione con Internet Explorer (4.0). Proprio questa scelta, unitamente ad alcuni problemi ancora non risolti nel supporto per l’USB, rende la prima release soggetta a frequenti crash e costringe Microsoft a correre ai ripari con Windows 98SE (Second Edition, maggio 1999), ritenuta ancora oggi la versione più stabile mai realizzata del filone 9x.

Come di consueto vi salutiamo con un interessante video in attesa del quarto post della serie.

Bill Gates and Brad Silverberg Windows 95 Launch