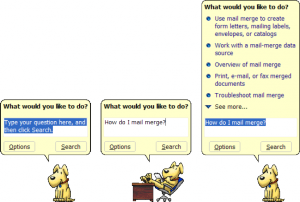

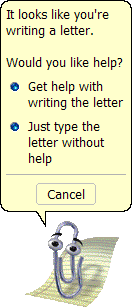

Diciamoci la verità: se non fosse costato troppo distruggere il monitor, credo che molti di noi si sarebbero tolti lo sfizio di scagliare la tastiera contro Clippy e soci, gli Assistenti di Office, dotati della capacità di apparire nei momenti meno desiderati e di porre la fantomatica domanda: “Would you like help?”, ovvero: “Hai bisogno d’aiuto?”

Clippy the Paperclip

Ma gli Office Assistant, erano in realtà un piccolo gioiello software, connubio tra tecnologico e sociologia.

Per capire cosa realmente si celava dietro quella goffa graffetta, che ha accompagnato esplicitamente Office fino alla release XP, bisogna infatti rifarsi alla teoria Computers Are Social Actors (CASA), 1994-1996, che afferma “one can take both thoeries and methods from social psychology and directly apply them to human-technology interaction”, ovvero che l’interazione con la tecnolgia sarebbe guidata da regole ed interpretabile secondo derivazioni dalla teoria delle relazioni sociali.

CASA è il risultato di uno studio effettuato presso l’Università di Stanford curato da Clifford Nass, Jonathan Steuer ed Ellen R.Tauber, con il supporto di Byron Reeves. Al centro della discussione viene posto l’accento sugli USER INTERFACE AGENT (UIA), una sorta di assistente che guida l’utente durante l’interazione con il sistema. Spiegare in modo puntuale cos’è uno UIA non è semplice, visto che esistono diverse scuole di pensiero. Uno User Interface Agent può essere descritto come un sistema disegnato per riprodurre i comportamenti umani (si parla anche di Intelligent Assistant), ma anche come un “semplice” componente che rende l’interfaccia utente più user-friendly.

Tra le software house che per prime cercano di cavalcare l’onda di CASA e degli UIA non poteva non esserci Microsoft, vista la sua vision ben precisa: “un computer in ogni casa” e la sua posizione dominante nel mondo del software.

BigM comincia una serie di studi creando un team specifico dedicato allo sviluppo di soluzioni tecnologiche per l’interazione uomo-macchina, basate in larga parte su CASA. Proprio Reeves, chiamato come consulente, sintetizza così il proprio lavoro di supporto alla società di Gates:

” The question for Microsoft was how to make a computing product easier to use and fun. Cliff and I gave a talk in December 1992 and said that they should make it social and natural. We said that people are good at having social relations – talking with each other and interpreting cues such as facial expressions. They are also good at dealing with a natural environment such as the movement of objects and people in rooms, so if an interface can interact with the user to take advantage of these human talents, then you might not need a manual.”

Una volta pronti i primi prototipi, Microsoft registra addirittura una serie di brevetti relative alle nuove tecnologie in grado di applicare, praticamente, i concetti dietro la teoria di Reeves e soci.

Tutto ciò si traduce nel 1995 in Microsoft BoB, il primo tentativo di “social interface” di Microsoft che introduce una GUI basata sul concetto di “stanza (room”), come ampiamente descritto qui da Alessio. Con BoB vengono concretamente implementati gli UIA, secondo entrambe le interpretazioni sopra descritte. Fanno, così, la loro comparsa gli Assistenti Animati, rappresentati da Avatar che si ispirano ad elementi di fantasia o anche personaggi storici, e i Wizard che semplificano l’interazione con l’interfaccia. Nel frattempo anche Packard Bell implementa una GUI basata sulle room, chiamata Navigator, ma priva degli UIA.

E’ in questo contesto che fa la sua comparsa il cane Rover, primo tentativo di creare un “assistente” che cerca di intuire le necessità dell’utente e suggerirgli possibili soluzioni. Certo il comportamente di Rover è statico e basato su elementi ben precisi, ma rappresenta comunque un terreno inesplorato fino a quel momento.

Nonostante BoB si rilevi un flop clamoroso, Microsoft ne riprende i concetti in buona parte dei software realizzati nell’arco del decennio successivo, attraverso i Wizard e gli “odiati” Assistenti di Office, con il portabandiera Clippy the Paperclip.

Lo sviluppo degli Agent fu incentrato su tre aspetti primari:

- Proactive Help System, ovvero un sistema di help proattivo che cerca di analizzare le azioni dell’utente e suggerire tip per velocizzarne le attività;

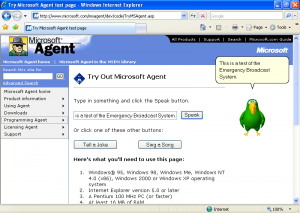

- Natural Language Help Query, la possibilità di “fare domande” al sistema attraverso un linguaggio naturale. In realtà questo elemento è slegato dagli Assistenti ed è utilizzabile anche attraverso la comune funzionalità di ricerca di Office e soci;

- Agenthood of the Program, ovvero l’agente si pone come l’interlocutore diretto con l’utente, mascherando, in parte, l’applicazione sottostante.

Natural Query

Dietro il Proactive Help ed il Natural Language Query si celava un progetto ben preciso: MS Lumiére, basato su un complesso modello matematico/statistico che cercava di predire il comportamento degli utenti e, quindi, proporre informazioni utili a velocizzarne il lavoro. Il sistema era incentrato sull’Inferenza Bayesiana (che considera la probabilità come livelli di fiducia nel verificarsi di un determinato evento) e suddiviso in 5 macro aree:

- la costruzione di modelli bayesiani per ragionare sugli obiettivi che gli utilizzatori vogliono raggiungere, lavorando sulle loro azioni e sulle loro richieste;

- interconnessione con un software terzo per analizzarne il flusso di eventi;

- motore di trasformazione degli eventi in variabili rilevanti per il modello bayesiano;

- sviluppo di profili persistenti per catturare la variazione di comportamento dell’utente;

- sviluppo di un’architettura globale per User Interface Agent Intelligenti (UIAI);

Per raggiungere gli ambiziosi traguardi di Lumière, Microsoft coinvolse figure, fino ad allora, completamente estranee al mondo informatico, come psicologi e sociologi, in piena sintonia con CASA.

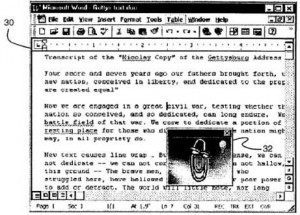

Ovviamente Lumière influenzò anche la modalità di gestione delle finestre all’interno delle GUI, visto che gli Assistenti Intelligenti eseguivano azioni in base ad eventi verificatisi in un’altra finestra. Ciò poneva in relazione tra loro queste due elementi distinti della GUI e, in particolare, l’Assistente doveva essere “informato” di ciò che avveniva. Vi dicono niente il pattern Observer o il classico Produttore/Consumatore?

Uno schizzo relativo al brevetto sull’interazione degli elementi della GUI

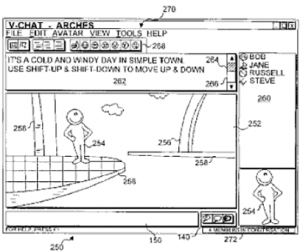

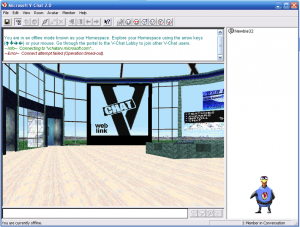

Tra i vari brevetti registrati dalla casa di Redmond merita menzione quello relativo alla tecnologia utilizzata da V-Chat, praticamente una sorta di Second Life con tanto di ambienti virtuali. E il riferimento non è casuale visto che nel 2002 alcune delle figure principali di Microsoft, nel settore delle Virtual World Platform, come Cheng, Farnham, and Stone, collaborano ad un libro che descrive nove linee guida per la realizzazione di mondi virtuali, basate sulle loro esperienze. Second Life, praticamente, fa proprie la maggior parte di esse.

V-Chat, tra l’altro, venne realmente implementano e supportato da Microsoft, ma ebbe una diffusione talmente bassa che fu velocemente abbandonato.

Schizzo per il brevetto di V-Chat e l’omonimo software

Viste le premesse e innovazioni tecnologiche sviluppate, perché Clippy ha fallito?

Paradossalmente proprio le fondamenta di Lumière hanno provocato la dipartita degli Assistenti. Una delle cause principali è infatti l’ “Anthropomorphic Dissonance”, ovvero la dissonanza antropomorfica che induce l’utente a credere che il piccolo assistente possa realmente comportarsi come un essere intelligente, essendo plasmato su comportamenti reali. Ciò porta a un’ampia frustrazione poiché, ovviamente, l’UIA non è in grado, almeno per ora, di andare al di là di quanto imposto dal suo creatore.

Un altro importante motivo di tale disfatta è il fatto che gli Assistenti mascherano il reale funzionamento del sistema, creando spesso confusione tra gli utenti avanzati, che preferisco avere il pieno controllo, e i neofiti che, invece, devono mediare i loro comportamenti.

Alcune delle ricerche legate agli UAI, addirittura, allontanato Microsoft da soluzioni più appropriate, facendole perdere terreno rispetto ai diretti concorrenti. Un esempio lampante è Earl, l’Internet Assistant di Redmond. Pensate che, praticamente, gli studi e lo sviluppo di questo simpatico surfista avvenivano mentre Page e Brin brevettavano il PageRank e fondavano Google.

Earl il Surfista

Tutta la tecnologia Microsoft relativa agli UIA è stata successivamente convogliata in Microsoft Agent, che tramite tools come MASH, Microsoft Agent Scripting Helper, permette di creare Agent Animati da utilizzare con presentazioni, messaggi inviati tramite e-mail, desktop, pagine web, ecc. Microsoft Agent è ormai ritenuta obsoleta e non più supportata, se non a livello di runtime, dal nuovo Windows 7.

Microsoft Agent

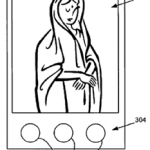

Gli studi sugli Assistant Agent, anche non legati direttamente alle UI, continuano incessantemente da parte di diverse aziende. La stessa Microsoft, intorno al 2006, ha brevettato una nuova serie di UIA per dispositivi portatili, pensati per aiutare persone con disabilità parziale o totale di lettura e/o scrittura, attraverso mimiche e sintetizzatori vocali.

UIA per dispositivi portatili

Anche i Motori di Ricerca Semantici per il web, che tentano di comprende cosa realmente l’utente sta cercando, piuttosto che ricercare le keyword o una loro semplice aggregazione, in fondo, ricordano molto quello che tentava di fare il povero Clippy.

Insomma, se si rilegge la storia di Clippy (e BoB) in chiave di attività di ricerca ed elementi, che poi hanno condizionato l’evoluzione del software non solo targato Microsoft, si scopre che tutto sommato la goffa graffetta non è stata un fallimento così grande come spesso si tende di dipingerla.